こんにちは。

株式会社オプト AIソリューション開発部のAIエンジニア、西川勇太です。

今回は、AIが時々”自信満々に間違う”現象、「ハルシネーション(Hallucination)」について、OpenAIが9月4日に発表した論文「Why Language Models Hallucinate」をもとに最新の知見を分かりやすくまとめます。

「なぜハルシネーションが起こるのか?」を理解し、AIの出力を鵜呑みにしない上手な付き合い方を考えてみましょう。

💡OPTのAI通信ではAIエンジニアが書く最新のAIニュースをお届けしております。

30秒で分かるまとめ

- AIは学習時の「正解率重視」の採点設計などにより、知らないことでも“もっともらしく答える”ハルシネーションを起こしやすい。

- ChatGPTや検索AIの回答は出典不明・古い情報を含む可能性があるため、出典確認・日付確認・複数ソースでのクロスチェックが不可欠。

- 最新性や根拠が重要な業務では、出典・確信度を出力させるプロンプト設計+検索AIによる一次情報確認で安全性と生産性を両立しよう。

ハルシネーション(Hallucination)とは?

もっともらしく見えて事実と異なる回答をAIが堂々と出してしまう現象を「ハルシネーション」と呼びます。たとえば人の誕生日や本のタイトルなど「正解が一つで、知らなければ答えられない」質問で起こりやすいとされています。

なぜ起きるのか?

要因の一つは、AI学習時の「採点設計(報酬関数)」です。多くの評価は正解率を重視するため、「分かりません」と答えるよりも、推測してでも答えるほうが高評価となります。

マークシート試験を想像してください。空欄は0点ですが、勘で正解すれば点が入ります。AIも同じように「言い切った方が得」という行動を学習してしまうのです。

論文でも「分からなければ答えないで」と指示しても、ハルシネーションは十分起こりうることが実験例と統計学的側面で示されています。AIは「もっともらしい偽情報」を出す方が高得点を得やすいと判断してしまうためです。

AIの答えはどこから来る?

大規模言語モデルは自然言語のパターンを学習しているだけで、真偽そのものを学習しているわけではありません。実用段階ではChatGPTやClaudeなどに質問して即座に答えを得ますが、多くの場合AIは出典を明示せず、学習済みパラメータに蓄えた知識を使って回答します。

このため次の点を理解しておく必要があります。

- 学習データは雑多な情報源を含み、出典不明の知識が混在する

- 学習時点は数か月〜数年前であり、最新情報ではない可能性がある

- 専門的・ニッチな領域は十分に学習されていない場合がある

TIP:最新性や根拠が重要な場合は、出典URL・出典名・最終更新日・確信度などを必ず出力するようプロンプトで指示しましょう。

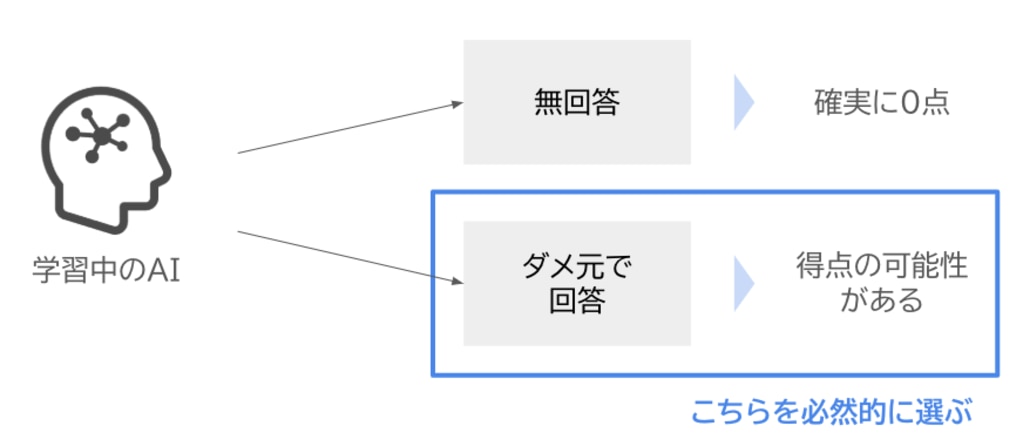

検索AIの活用

Web検索エージェントを併用すると、出典が明示されやすく、更新日も確認しやすくなります。

9月9日から日本で順次提供されているGoogleのAIモードは、回答に出典リンクを付けたり、必要に応じて関連画像を表示してくれます。

ただしAI「検索」だからって安全じゃない

Web検索エージェントの回答は要約に過ぎません。見出しやスニペットが正確でも、本文が裏付けていない、日付が古い、一次情報ではないことがあります。確実な情報が必要な場合は、必ずリンク先の一次情報を確認しましょう。

確認ポイント

- リンクを開く:公式リリースや法令、原論文など一次情報に当たる

- 日付を確認:公開日・最終更新日・データ収集期間を把握する

- 独立した複数ソース:同一記事の焼き直しは独立情報とみなさない

- 主張と引用の対応:どの段落や図表が根拠なのか自分の目で確かめる

- 数字・単位の整合:桁・通貨・期間・母数までチェックする

まとめ

AIは「よく働く部下」ですが、根拠を伴う使い方が欠かせません。

出典・日付・確信度などを明示させ、必要に応じて検索AIで一次情報を押さえることで、安全性と生産性を両立できます。

業務課題に対するAI活用をお考えの方へ

弊社では、クライアントの業務課題に対して、

AI技術と業界知見を掛け合わせたソリューション提案を行っております。

- 業務効率化や自動化の可能性を検討したい

- 社内のデータを活かして、AI導入を進めたい

- 情報収集やリサーチの仕組みを改善したい

など、どんな段階でも構いません。まずはお気軽にご相談ください。

出典

[1] A.T. Kalai, O. Nachum, S.S. Vempala, E. Zhang, “Why Language Models Hallucinate,” arXiv:2509.04664, 2025-09-04. DOI: 10.48550/arXiv.2509.04664

[2] OpenAI, “Why language models hallucinate,” 2025-09-05

[3] Google, 「検索におけるAIモードを日本語で提供開始」2025-09-09

オプトのメールマガジンではデジタルマーケティングに役立つ事例をはじめ

セミナー開催情報、お役立ち資料、最新メディア情報などをお届けします

© OPT, Inc.